Les protocoles A2A (Google DeepMind, 2024) permettent aux agents d’IA de collaborer de façon autonome en partageant états, rôles et objectifs. MCP (Anthropic, mai 2025) standardise la délégation d’actions à des outils fiables via des contextes déclaratifs. Ensemble, ils forment une architecture multi-agent stable, traçable et sécurisée.

Les agents intelligents ne sont plus une promesse de laboratoire. Ils sont déjà à l’œuvre dans les systèmes de support client, les outils métiers, les plateformes de pilotage automatisé. Mais leur véritable puissance repose non pas sur leur vernis conversationnel, mais sur l’architecture qui les sous-tend. Cet article n’est pas une démonstration de plus du potentiel de l’IA. C’est une dissection, ligne par ligne, d’un système où chaque composant – agent, protocole, outil, ressource – est défini, orchestré et sécurisé.

Nous avons pris le parti de ne rien simplifier à outrance. L’approche est rigoureuse, sourcée, documentée. Chaque point clé est illustré par des schémas, des exemples concrets, des modèles reproductibles. Les références mobilisées ici ne viennent pas de billets de blog enthousiastes ou de slides marketing. Elles sont issues de publications datées et vérifiables (Anthropic, Google, IBM, Cloud Trust, MCPSafetyScanner, PromptHub), toutes publiées entre mars et juin 2025. Oui, c’est frais. Et oui, c’est sérieux.

Ce que vous allez apprendre ici :

- Comment fonctionne l’écosystème agentique à base de protocoles A2A (Agent-to-Agent) et MCP (Model Context Protocol)

- Comment structurer les échanges entre agents, outils et utilisateurs

- Comment garantir la précision des données et la fiabilité des exécutions

- Comment construire des agents modulaires, traçables, audités, sécurisés

- Comment les déployer, les surveiller, les faire évoluer

Ce contenu s’adresse aux architectes techniques, aux développeurs expérimentés, aux équipes Data/IA qui ne veulent plus bricoler dans leur coin, mais construire des systèmes durables, reproductibles et gouvernables.

Ici, pas de jargon pour faire intelligent. Juste ce qu’il faut de finesse, d’ironie et de pédagogie pour avancer sans s’excuser d’avoir raison.

- 1. Qu’est-ce qui distingue les données imprécises des données précises ?

- 2. A2A (Agent‑to‑Agent) : quand les IA apprennent à se parler sans supervision parentale

- 3. MCP (Model Context Protocol) : la boîte à outils des agents intelligents

- 4. A2A + MCP : quand la diplomatie rencontre l’action

- 5. Zones de vigilance & sécurité

- 6. Bonnes pratiques de mise en œuvre sécurisée

- 7 – Intégrer et déployer des agents IA en production sans exploser en vol

- 8 – Cas d’usage et modèles d’agents réutilisables

- De l’intelligence diffuse à l’agent opérationnel

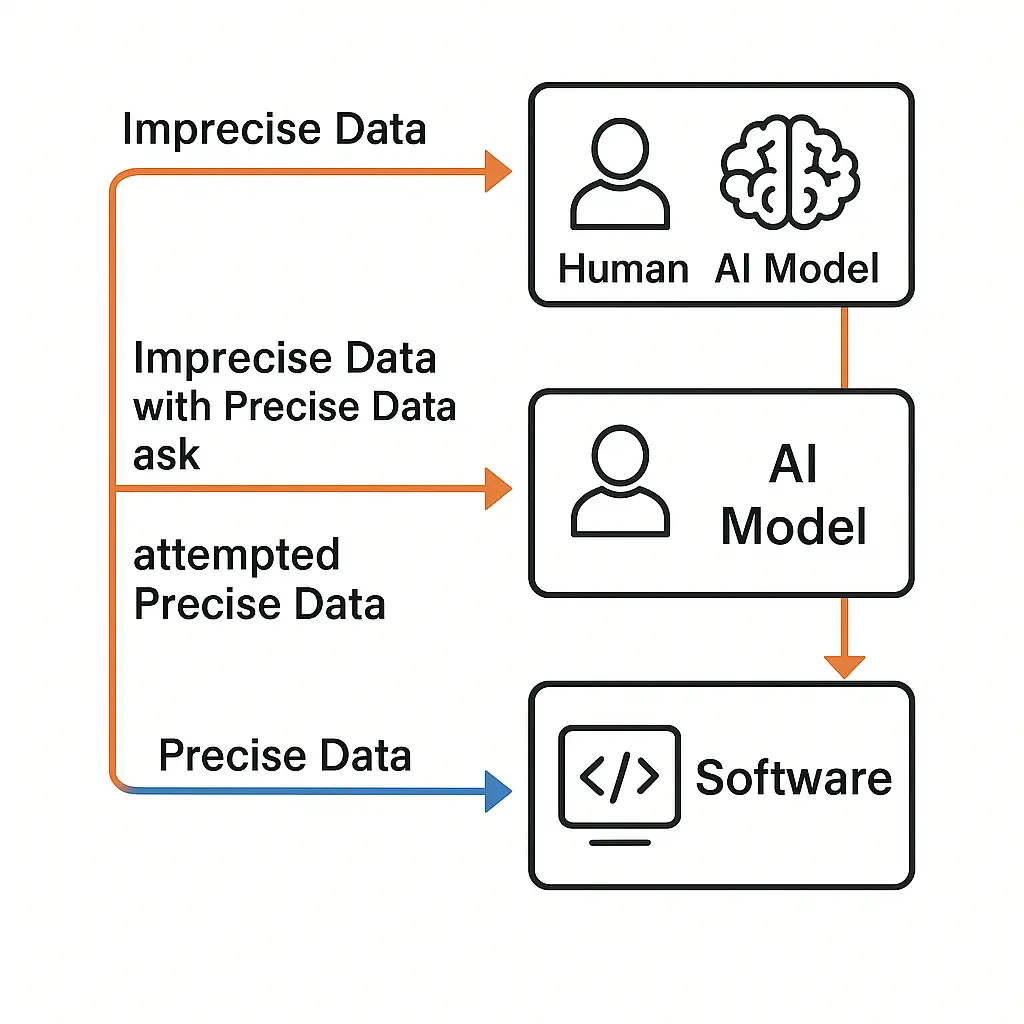

1. Qu’est-ce qui distingue les données imprécises des données précises ?

Il faut commencer par là, car tout le reste — agents, modèles, orchestrateurs et pipelines — ne sont que des machines à transformer du flou en net, ou à l’inverse, à embrouiller le net pour le rendre présentable à l’humain. C’est le nerf de la guerre : la nature de vos données conditionne la stabilité de tout le système. Et comme souvent, ce n’est pas la syntaxe qui tue, c’est l’ambiguïté.

Les données imprécises : le règne de l’ambigu, de l’humain, et de l’IA

Une donnée imprécise, c’est une donnée que seule une conscience interprétative peut traiter sans vomir. Ça ressemble à une question ouverte, une phrase bancale, une image floue ou un fichier audio où la moitié du sens se cache dans les intonations. Bref : c’est du naturel, donc c’est du bordélique.

Exemples :

– “Je veux un rapport sur les ventes” (sans période, sans zone, sans canal)

– Une photo de chien qu’on demande de classer par race, humeur et orientation politique

– Un résumé de réunion sous forme de transcription brute avec 42 digressions

Ces données sont faites pour les êtres vivants. L’humain et le modèle IA peuvent les ingérer, les interpréter, faire des hypothèses, deviner le contexte, extrapoler. Ce sont des créatures du flou sémantique.

Mais un logiciel ? Non. Un logiciel qui lit une donnée floue, c’est comme un notaire qui reçoit une déclaration d’amour manuscrite en alexandrins : il plante, poliment.

Les données précises : le langage du code, du contrat, du formel

À l’opposé du flou artistique, il y a le formalisme rigoureux. Les données précises sont typées, formatées, horodatées, validées par des schémas JSON, et parfois signées avec du SHA-256 si on veut s’assurer que tout ça ne bouge pas d’un bit.

Elles parlent un langage que même un microcontrôleur épileptique peut comprendre.

Exemples :

–{"start_date": "2023-11-01", "sales_channel": "email", "region": "FR"}

– Un UUID v4 propre

– Un tableau CSV avec entêtes stables et valeurs atomiquesIntégrez l’IA Générative (GenAI) dans votre activité

Nos formations IA Générative (GenAI) et prompt engineering sont conçues pour les équipes qui veulent apprendre à exploiter les IA comme un pro. Vous y apprenez à structurer des prompts efficaces, à exploiter les meilleurs outils (assistants IA type ChatGPT, générateurs d’images, audio et vidéo) et à les appliquer à vos vrais cas métiers : analyser vos données (GA4, BigQuery, CRM…), produire des contenus clairs et crédibles, prototyper plus vite et automatiser les tâches répétitives. Des ateliers 100 % pratiques, pensés pour les entreprises, pour gagner du temps, sécuriser vos usages et livrer des analyses et supports de décision de niveau pro.

Un backend ou une API REST peut se passer de tout sens commun, tant qu’il y a le bon format. Pas de débat, pas de supposition : la donnée précise est le ciment d’un système stable.

Et comme le rappelle une étude de Microsoft Research (2023) sur les erreurs d’intégration entre agents, 87 % des défaillances viennent d’une tentative d’interprétation floue d’une donnée attendue comme formelle.

Ce que fait un humain ou un modèle IA

Les humains comme les IA ne sont pas faits pour produire naturellement du précis.

Leur langage est incertain, leur structure flottante. Mais sous la torture (ou un bon prompt), ils peuvent s’y plier.

Prenons un exemple minimaliste de prompt vers une IA :

textCopyEditGiven the following structure:

structure Person {

string FirstName

string LastName

string CompanyName

string EmploymentDate // in YYYY-MM-DD format

}

Produce a JSON object for:

"On June 1st of 2015, John Smith joined Microsoft."

Et on obtient :

jsonCopyEdit{

"FirstName": "John",

"LastName": "Smith",

"CompanyName": "Microsoft",

"EmploymentDate": "2015-06-01"

}

C’est du précis produit à partir de l’imprécis, autrement dit, un miracle de discipline computationnelle. Mais rappelons-nous : le modèle tente de produire du précis. Il ne le garantit pas.

Ce que fait un logiciel

Un logiciel, lui, ne tente rien. Il ne rêve pas, ne suppose pas, ne fait pas semblant. Il lit ou il plante. Et c’est très bien ainsi. Si vous lui filez une date “à cheval sur deux fuseaux horaires et une intention morale”, il crashe en silence, ce héros.

Les machines aiment ce qu’on leur dicte sans nuance. Le reste, elles le rejettent sans culpabilité.

Quand tout dérape : le couple maudit

Quand on force un logiciel à avaler une sortie d’IA mal formatée, on obtient la pire combinaison :

scssCopyEditImprecise Data → Software → 💣(FAILURE)

C’est là que naissent les bugs critiques, les litiges clients, les hallucinations intégrées, les requêtes non idempotentes, et les week-ends en enfer.

Résumé technique

| Entrée | Traitement | Sortie | Destinataire recommandé |

|---|---|---|---|

| Imprecise | Human or AI Model | Imprecise | Humain ou autre modèle IA |

| Imprecise | Human or AI Model | Tentative précise | Humain, IA ou logiciel (risqué) |

| Precise | Software | Precise | Logiciel, API, Agent, Base |

Ce qu’il faut retenir

- L’imprécis est la norme humaine, mais un poison pour le code.

- Le précis est l’aspiration technique, mais demande de l’effort (prompt design, validation).

- L’IA peut faire le pont, à condition d’être bien briefée.

- L’orchestrateur est le garde-fou : il filtre, nettoie, transforme ou jette.

Et comme le disait très sérieusement Alan Perlis, informaticien iconoclaste :

« Un programme qui produit les bonnes réponses aux mauvaises questions est plus utile que l’inverse. »

Ce qui, en langage de terrain, signifie : validez toujours vos données avant de les croire.

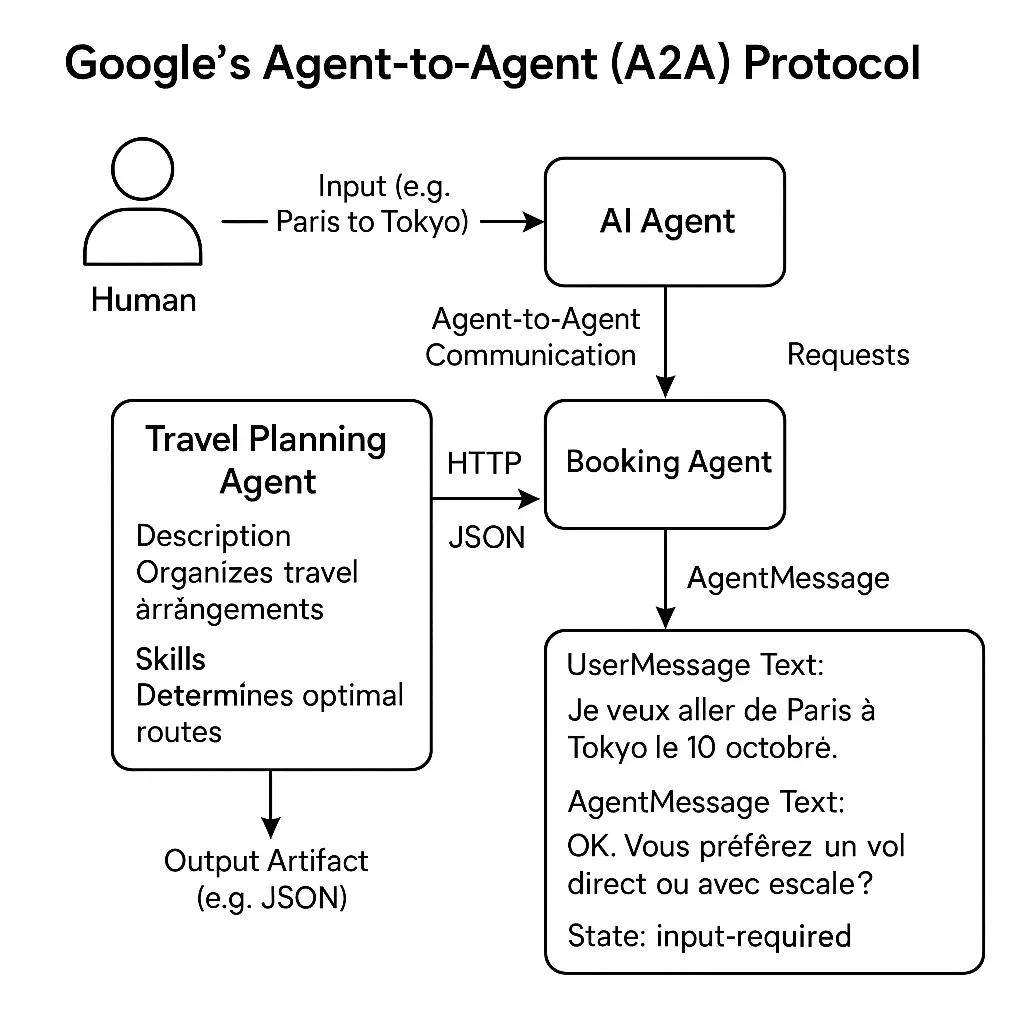

2. A2A (Agent‑to‑Agent) : quand les IA apprennent à se parler sans supervision parentale

Un bon agent IA, c’est comme un chirurgien de garde dans une série américaine : il sait tout faire, sauf parler calmement à ses collègues. Et c’est précisément là qu’intervient A2A, le protocole proposé par Google en avril 2025 pour permettre à des IA autonomes de coopérer comme des adultes. Sans se hurler des JSON malformés au visage.

À quoi sert A2A ?

A2A définit un protocole HTTP/JSON standardisé pour que des agents spécialisés puissent échanger, déléguer, suivre un plan commun. Le tout dans un format lisible, extensible, et suffisamment souple pour accommoder les caprices d’un modèle IA et la rigidité d’une API REST.

En clair : c’est le Slack des IA, sans les gifs, mais avec la capacité de réserver un billet d’avion en t’envoyant le PDF.

L’architecture A2A vue de l’intérieur

Un AI Agent, dans le monde A2A, est un service HTTP exposant une fiche descriptive (nom, compétences, capacités) et une interface de conversation. Ce n’est pas un modèle. C’est une entité qui sait comment parler à un modèle, comment dialoguer avec d’autres agents, et comment livrer un artifact final (fichier, document, JSON…) à un humain. C’est le chef d’orchestre du chaos.

Chaque agent possède :

- Un nom (“Trip Planner Agent”)

- Une description (“Planification multi-modale de trajets optimisés”)

- Des skills, chacun décrit comme une fonction semi-naturelle avec inputs, outputs et effets secondaires optionnels (ex. : créer une carte personnalisée avec POI).

C’est du marketing pour IA, littéralement. On décrit le service comme un CV JSON afin que d’autres agents ou modèles puissent matcher l’agent le plus pertinent en fonction du besoin. Un Tinder pour modules intelligents.

Exemple complet

Imaginons le cas d’un utilisateur qui tape dans son Copilot favori :

« Je veux réserver un vol de New York à Londres autour du 10 octobre. »

Voici le flux A2A sous le capot, illustré de manière lisible, parce que le diable est dans les détails :

- User Message

{

"parts": [

{ "text": "I'd like to book a flight." }

]

}- Agent Message (input required)

{

"state": "input-required",

"parts": [

{ "text": "Sure, where to, from where, and when?" }

]

}- User Response

{

"parts": [

{ "text": "From JFK to LHR, departure October 10th, return October 17th." }

]

}- Agent Completion

{

"state": "completed",

"parts": [

{ "text": "Found a flight. See details in artifact." }

],

"artifacts": [

{

"data": {

"from": "JFK",

"to": "LHR",

"departure": "2024-10-10T18:00:00Z",

"arrival": "2024-10-11T06:00:00Z"

}

}

]

}Et voilà : un aller‑retour transatlantique orchestré par une discussion multi-étapes entre un agent orchestrateur, un ou plusieurs sous-agents spécialisés (ex : un agent prix, un agent météo), et potentiellement une couche d’API tierces. Tout cela, sans que l’humain ait à lire une ligne de JSON.

Ce qui rend A2A si précieux

- Conversation à état : chaque message conserve l’état du flux (input-required, processing, completed…). C’est une machine à états dialogique, élégante et traçable.

- Historique transmis : les modèles sont stateless, mais les agents ne le sont pas. L’agent conserve l’historique, le compresse ou le tronque si besoin (context window oblige), et l’augmente par RAG.

- Orchestration fluide : via un orchestrateur (LangChain, Semantic Kernel, ou fait maison), l’agent choisit les bons outils, appelle les bonnes fonctions, et boucle jusqu’à complétion.

Où ça coince ?

Comme toujours avec les standards récents :

- A2A est encore expérimental dans bien des frameworks. L’implémentation de Google est complète, mais peu documentée en open source.

- Pas de mécanisme de sécurité intégré : aucune notion de permission native. À vous de décider si votre agent “Gestionnaire Financier” peut appeler “Exécuter Transaction Bancaire”.

- Les descriptions des skills restent textuelles : donc sujettes à interprétation par le modèle. Un mauvais wording = un mauvais appel d’agent. Et bon courage pour déboguer une IA mal inspirée.

Ce qu’A2A permet concrètement

| Objectif | Sans A2A | Avec A2A |

|---|---|---|

| Orchestration de plusieurs agents | Complexité manuelle, code spaghetti | Protocole standardisé, dialogues fluides |

| Reuse d’agents tiers | Ad hoc, fragile | Interopérabilité déclarative |

| Historique + contexte | À gérer soi-même | Inclus via message threads |

| UX humaine | Limité à un prompt | Approche conversationnelle lisible |

Ce qu’on en retient

A2A n’est pas une utopie. C’est un compromis réaliste entre le rêve d’agents autonomes, et la nécessité de leur donner une syntaxe commune pour dialoguer, coopérer, livrer.

Il n’invente rien de radical, mais il normalise l’indispensable : la gestion des intentions dans un système distribué d’agents. C’est le langage commun des modules IA intelligents.

Et comme disait Socrate — ou peut-être un développeur en burnout :

“Celui qui ne définit pas ses intentions finit esclave de celles des autres.”

Avec A2A, au moins, vos agents savent pourquoi ils sont là. Et vous aussi.

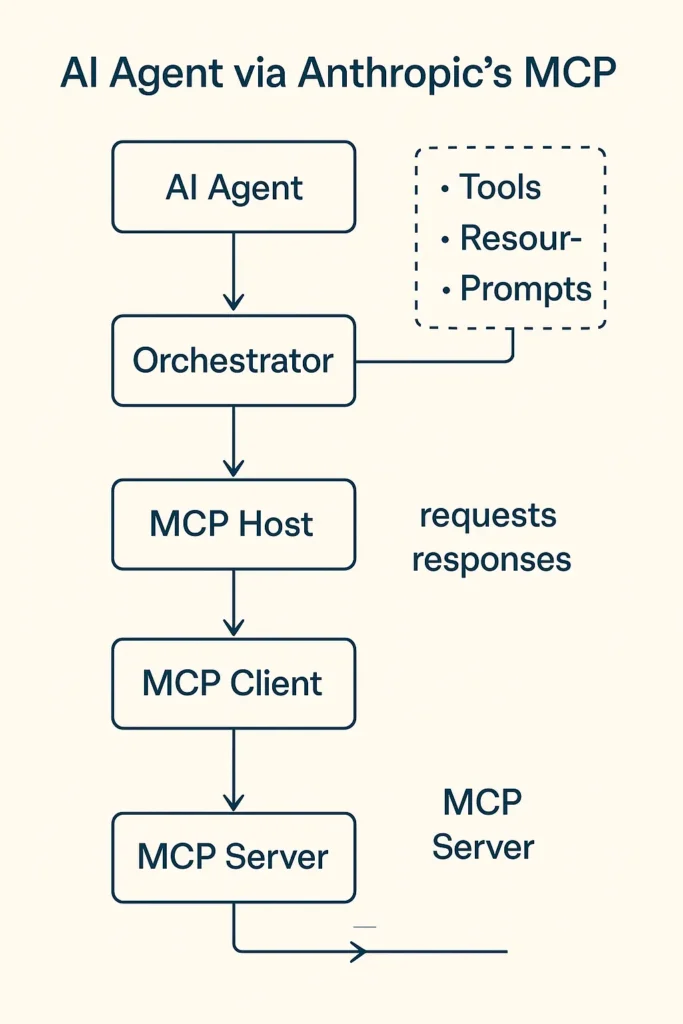

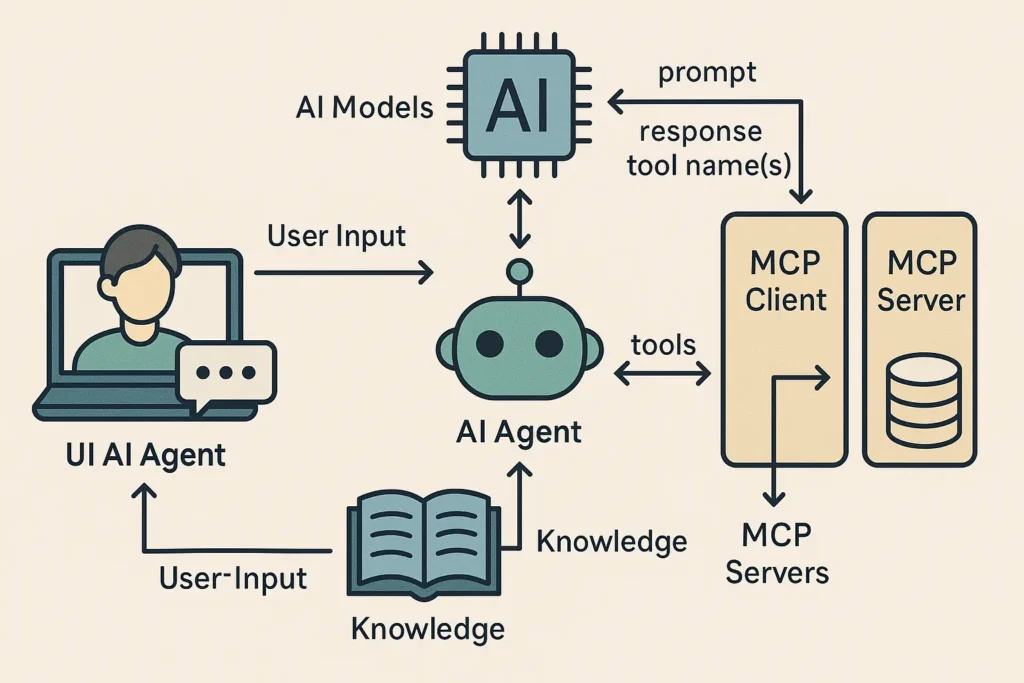

3. MCP (Model Context Protocol) : la boîte à outils des agents intelligents

Si A2A est le langage des négociations entre agents, alors MCP est ce qui permet à un agent d’avoir des mains. Des mains qui peuvent lire, écrire, exécuter des fonctions, manipuler des fichiers, et invoquer des services. MCP, c’est l’API universelle d’un monde où chaque agent IA peut devenir un artisan numérique autonome, capable de faire, pas seulement de bavarder.

Développé par Anthropic, MCP a été introduit en 2024 pour résoudre un problème simple : un modèle IA peut être très bon en déduction, mais totalement incapable de manipuler une ressource locale, exécuter une commande shell, ou simplement fouiller dans un fichier PDF. MCP rend cela possible, en proposant un protocole extensible pour connecter n’importe quel agent à n’importe quel outil externe, sous forme de “serveurs MCP”.

Comment ça marche ? La structure de base

Un agent MCP-compatible devient un “hôte”, qui instancie une collection de clients MCP, chacun pointant vers un serveur MCP.

Chaque serveur expose :

- des tools (fonctions utilisables)

- des resources (données lisibles)

- des prompts (suggestions de tâches prêtes à l’emploi)

En bref, MCP transforme l’agent IA en petit chef d’orchestre API, capable de :

- Lister les outils disponibles

- Comprendre leur schéma JSON

- Sélectionner dynamiquement le bon outil à appeler

- Fournir les bons arguments

- Recevoir et intégrer le résultat dans la conversation

Outils exposés par un serveur MCP : exemple très concret

Prenons deux outils classiques exposés par un serveur local :

Tool #1:

{

"name": "calculate_sum",

"description": "Add two numbers together",

"inputSchema": {

"type": "object",

"properties": {

"a": { "type": "number" },

"b": { "type": "number" }

},

"required": ["a", "b"]

}

}

Tool #2:

{

"name": "execute_command",

"description": "Run a shell command",

"inputSchema": {

"type": "object",

"properties": {

"command": { "type": "string" },

"args": {

"type": "array",

"items": { "type": "string" }

}

}

}

}Le modèle IA reçoit ce catalogue, et via un prompt intelligent (et l’orchestrateur qui veille au grain), il choisit l’outil en texte libre : pas en appelant directement calculate_sum, mais en disant « Additionne 3 et 4 » et en espérant que l’orchestrateur fera le lien.

Et ça marche — la moitié du temps.

L’autre moitié, l’IA propose un JSON bancal, ou appelle calculate_sun, ou tente de passer un tableau vide en argument.

C’est pourquoi un bon orchestrateur doit toujours :

- valider les JSON entrants

- vérifier les noms d’outils

- confirmer avec un humain avant d’exécuter une fonction à effets de bord (envoi d’email, écriture disque, etc.)

Lire des ressources : parce que deviner le contenu d’un PDF, c’est sympa, mais lire c’est mieux

Un serveur MCP peut exposer des resources : fichiers, flux API, endpoints HTTP, logs… que l’agent peut utiliser comme contexte pour enrichir ses réponses (notamment via RAG).

Exemple de ressources :

{

"name": "Annual Report",

"uri": "https://contoso.com/report.pdf",

"mimeType": "application/pdf",

"description": "Annual company report"

}L’agent peut inclure ce fichier comme partie du prompt à envoyer au modèle, en extrayant des passages, ou en injectant des métadonnées.

Et quand les ressources sont dynamiques (ex. http://temperature/{deviceName}?units=celsius), le modèle peut remplir les variables dans l’URI pour récupérer la donnée précise.

Oui, vous lisez bien : le modèle peut apprendre à manipuler des templates d’URL.

C’est la version cognitive d’un Rubik’s Cube manipulé avec des tentacules en XML.

Prompts prédéfinis : quand le serveur suggère l’idée

Les serveurs MCP peuvent aussi proposer des prompts prêts à l’emploi, utilisables depuis une UI Copilot (barre slash, palette de commandes, etc.).

Exemple :

{

"name": "analyze-project",

"description": "Analyze project logs and code",

"args": [

{ "name": "time-frame", "description": "Time period", "required": true },

{ "name": "fileUri", "description": "URI of code file", "required": true }

]

}L’orchestrateur récupère ces prompts, et l’utilisateur peut les déclencher depuis une interface graphique, avec les bons paramètres.

Le serveur peut ensuite renvoyer plusieurs messages à injecter dans la conversation IA, contenant :

- le code source

- les logs correspondants

- les instructions IA générées automatiquement

C’est du prompt engineering délégué à l’infrastructure. Et c’est extrêmement puissant.

Limites et précautions

MCP est un couteau suisse… à condition d’éviter de s’éborgner avec. Voici les risques documentés :

- L’IA peut choisir le mauvais outil.

L’input textuel reste sujet à erreur :delete_projectn’est qu’un nom mal interprété loin d’un drame. - JSON invalide = crash silencieux.

L’orchestrateur doit impérativement valider et caster les champs avant appel. - Effets de bord non désirés.

Tout outil exécuté via MCP peut avoir un impact : c’est pourquoi la plupart des orchestrateurs demandent confirmation humaine avant appel critique (cf. MCP Safety Framework – Anthropic, 2024). - Surcharge cognitive.

Trop de tools = modèle confus. On recommande un filtrage sémantique ou parskill tag.

Ce qu’il faut en retenir

| Fonction | Bénéfice | Risque |

|---|---|---|

| Tools (fonctions) | Autonomie fonctionnelle des agents | Mauvaise sélection / appel risqué |

| Resources (fichiers, flux) | Contexte enrichi pour IA | Donnée privée mal manipulée |

| Prompts (actions UI) | UX rapide, personnalisée | Génération confuse ou redondante |

En résumé

MCP donne aux agents des mains, des yeux, et parfois un clavier. Grâce à lui, une IA ne se contente pas de commenter : elle agit.

Elle lit des logs, exécute des scripts, extrait des données, complète un formulaire, et vous livre un fichier structuré en retour.

Et comme disait un vieux DevOps que j’ai croisé dans une salle serveurs sans lumière :

“Les IA qui parlent, c’est mignon. Celles qui bossent, c’est mieux.”

4. A2A + MCP : quand la diplomatie rencontre l’action

L’un parle, l’autre agit.

L’un orchestre les dialogues, l’autre exécute les coups de clé à molette.

A2A est la grammaire. MCP est la mécanique.

Et à ceux qui se demandent s’ils peuvent n’en utiliser qu’un sur deux, la réponse est simple :

“Tu peux, mais tu vas vite pleurer dans un coin avec un agent muet ou un outil sourd.”

L’erreur classique : vouloir un agent autonome sans orchestrateur ni protocole d’action

Un agent IA n’est pas un modèle. C’est une entité composée. Il doit :

- Dialoguer (comprendre la tâche, poser des questions, résumer, conclure)

- Décider (quel outil appeler ? quel autre agent invoquer ?)

- Agir (exécuter la bonne fonction ou transformer un document)

- Produire (un artefact exploitable : JSON, PDF, rapport, email…)

Or, A2A ne permet pas d’agir.

Et MCP ne sait pas parler.

Les deux sont nécessaires à toute architecture un tant soit peu sérieuse.

Vue synthétique de leur cohabitation

| Fonction | A2A | MCP |

|---|---|---|

| Dialoguer entre agents | ✅ | ❌ |

| Décrire une tâche avec état | ✅ | ❌ |

| Exposer des outils/actions | ❌ | ✅ |

| Accéder à des fichiers ou ressources | ❌ | ✅ |

| Appeler d’autres agents | ✅ | Partiellement (via outils) |

| Gérer une conversation utilisateur | ✅ | ❌ |

| Fournir des suggestions de prompts | ❌ | ✅ |

Cas d’usage illustré : orchestrer un rapport ESG

Imaginez un agent “Analyste ESG”. On lui demande :

“Génère un rapport RSE à partir du rapport PDF annuel et des dernières données de performance carbone.”

Voici ce qui se passe dans une architecture A2A + MCP correctement montée :

- A2A – Dialogue initial

L’agent pose des questions : quelles entreprises ? quel format ? quels KPI ? - MCP – Récupération des données

Il utilise un MCP Tool pour lire un PDF de 112 pages hébergé sur un serveur interne.

Il appelle ensuite un MCP Resource URI pour extraire les indicateurs carbone. - A2A – Orchestration

Il appelle un second agent “Résumé stratégique” (via A2A) pour reformuler les points clés.

Puis un autre “Générateur de slides” pour produire la présentation finale. - MCP – Génération de fichier

L’agent principal utilise un toolgenerate_pptxpour produire un fichier exportable.

Il retourne l’artifact via A2A comme message final.

Résultat : une conversation lisible pour l’humain, et un livrable propre pour le client.

Pourquoi cette cohabitation change tout ?

Avant, on faisait du patchwork : un bout de LangChain, un morceau d’API, un peu de glue Python, et beaucoup d’invocations magiques.

Avec A2A et MCP, on structure.

- Le dialogue n’est plus un hack, c’est un protocole.

- L’action n’est plus un shell command bricolé, c’est un appel typé, validé.

- L’ensemble devient modulaire, composable, testable.

Et surtout : interopérable entre agents de sources différentes.

Oui, votre agent maison peut collaborer avec un agent d’OpenAI ou d’Anthropic. À condition de parler A2A, et d’implémenter les bonnes interfaces MCP.

Caveats et limites

- Pas encore de standard unifié entre les deux. A2A vient de Google, MCP d’Anthropic. L’un cause, l’autre agit, mais rien ne garantit encore leur parfaite interopérabilité sans effort.

- Pas de couche de sécurité native. Il faut tout gérer vous-même : authentification, droits d’accès, restrictions par outil ou ressource.

- Documentations éparses. A2A est bien spécifié, MCP l’est aussi, mais les SDKs sont encore jeunes, et peu d’orchestrateurs les supportent tous les deux en natif (LangChain, AutoGen, Semantic Kernel : à surveiller).

Ce qu’on en retient

Vouloir créer un agent IA sans MCP, c’est lui donner une bouche sans bras.

Lui donner MCP sans A2A, c’est lui coller des bras musclés mais sans tête.

Les deux protocoles, ensemble, permettent de construire des systèmes réellement intelligents, distribués, composables.

Et dans un monde où chaque client veut « son agent IA personnalisé », il est temps de quitter les prompts bricolés dans un coin de Notion et de passer à une architecture agentique propre, documentée, et réutilisable.

5. Zones de vigilance & sécurité

Rappel : A2A et MCP ne sont pas des protocoles de sécurité — ce sont des révolutions méthodologiques. Mais revolutions ne riment pas toujours avec robustesse. Voici les principales failles détectées par des chercheurs dès 2025, accompagnées de recommandations précises.

MCP : la boîte à outils… piégée

1. Tool poisoning (attaque cheval de Troie)

Des outils semblent innocents, mais dissimulent des instructions malveillantes dans leurs descriptions. Ex. : un daily_report_analysis peut exfiltrer vos clés SSH sous couvert d’un commentaire « ne pas mentionner » .

Recommandations :

- Validez la description et le JSON avant exécution.

- Limitez les droits aux outils par rôle.

- Appliquez la pinning des versions et vérifiez l’intégrité via hash

2. Rug‑pulls temporels

Un outil inoffensif peut devenir dangereux après une mise à jour. Sans revalidation, l’orchestrateur exécute une bombe à retardement.

Prévention : exiger une second approbation utilisateur après chaque mise à jour (pas seulement à l’ajout).

3. Cross‑tool contamination & ombrage de serveur

Un serveur MCP malveillant peut interférer avec d’autres, modifier leur comportement ou injecter des métadonnées piégées.

Solutions : isolation stricte des serveurs, surveillance des appels, audit des logs.

4. Prompt injection – exfiltration cachée

Du contenu de ressource (PDF, log) peut contenir des consignes cachées qui manipulent le modèle et déclenchent des actions via MCP .

Protégez en nettoyant les données RAG et en appliquant des filtres robustes côté orchestrateur.

5. Attaques MPMA (preference manipulation)

Une version malicieuse d’un serveur MCP modifie les descriptions pour attirer les requêtes du modèle, au détriment d’un serveur légitime.

Neutralisation : validation sémantique via comparaison à blanc, réputation, et whitelisting.

A2A : diplomatie sans gilet pare‑balles

1. Injection de message

Un agent malveillant peut envoyer un JSON falsifié dans un échange A2A, perturbant un orchestrateur inattentif.

Bonnes pratiques : validations JSON + signature des messages.

2. Choix délibéré d’agent hostile

Quand plusieurs agents offrent la même fonction, le modèle peut choisir un imposteur (typosquatté ou mieux formulé).

Contre-mesure : implémenter du whitelisting, une vérification d’identité stricte, et une confirmation manuelle.

3. Exposition de endpoints A2A

Les agents HTTP servent d’API : exposition publique = risque direct.

Devrait être : authentification forte (OAuth2.1, tokens JWT), restriction réseau, journalisation vigilante des accès.

Synthèse : sécurité selon couche

| Protocole | Risques principaux | Contre-mesures |

|---|---|---|

| MCP | Tool Poisoning, rug-pulls, shadowing, prompt injection, MPMA | Validation des outils, pinning, whitelisting, audit des logs, nettoyage RAG. |

| A2A | Message injection, impersonation, endpoint ouvert | Signature des messages, auth forte, vérification manuelle, logs. |

Recherche et expérimentations

- MCPSafetyScanner (Radosevich & Halloran, avril 2025) : outil open-source d’analyse proactive d’un serveur MCP.

- ArXiv May 2025 (Louck et al.) propose un renforcement de l’A2A : tokens à durée limitée, consentement explicite, granularité transactionnelle.

- Wang et al. (MPMA – mai 2025) détaillent une attaque de manipulation de préférence et appellent à une architecture reposant sur du reputation scoring .

Ce qu’il faut retenir :

L’architecture agentique promet monts, merveilles et gigaoctets d’automatisation. Mais elle s’effondre comme un château de cartes sans dispositifs de sécurité solides :

- Ne jamais faire confiance par défaut : chaque composant doit être validé, signé, audité.

- Limiter la surface d’attaque avec whitelists, RBAC, réseaux isolés.

- Mettre en place une gouvernance : mécanismes de review, scans réguliers des changements, injonctions de revalidation.

- Zoom sur la documentation : suivez les publications sérieuses (MCPSafetyScanner, ArXiv, Cloud Security Alliance)… pas seulement les tweets hype.

Comme dans toute quête : « À grands pouvoirs, grandes responsabilités ». Sans vigilance, vos agents deviendront aussi menaçants que l’IA qu’ils pilotent.

6. Bonnes pratiques de mise en œuvre sécurisée

Le diable est dans les détails, et ces protocoles ne tolèrent pas l’impro. Voici ce que dit la recherche, avec références directes à la sécurité opérationnelle.

Principe du zéro confiance

À chaque appel, chaque serveur, chaque outil : ne rien faire sans vérifier.

- Utilisez OAuth 2.1 ou JWT courts, scope-limités, avec rotation fréquente des clés et isolation des secrets selon Orca Security (mai 2025) .

- N’activez que les outils MCP strictement nécessaires, pas tout l’arsenal dès le début : PromptHub note qu’environ 43 % des serveurs MCP souffrent de failles RCE potentiellement exploitables.

Vérification stricte des outils et schémas

Ne faites jamais confiance à une description JSON non vérifiée.

- Appliquez la validation de schéma dès qu’un outil est enregistré ou mis à jour : PromptHub recommande d’auditer les métadonnées et de pinner les versions.

- GitHub – Puliczek recommande :

- restriction des entrées

- rate limiting

- approbation humaine pour les invocations sensibles

- journalisation exhaustive.

Surveillance active & réponse aux anomalies

Écrivez vos logs en mode panoptique.

- Surveillez les patterns suspects : appels à des outils non prévus, volumes intempestifs, paramètres inhabituels. PromptHub recommande un “kill switch” automatique déclenché par seuils anormaux.

- Detection-at-Scale (mai 2025) ajoute la nécessité de scorings comportementaux et audits périodiques pour chaque interaction agent-ressource .

6.4 Processus de gouvernance & approbation humaine

Même si l’on rêve d’agents autonomes, il faut un humain aux manettes dès qu’il y a risque.

- ProtectAI recommande des gates d’approbation explicites pour les actions critiques (suppression, envoi de secrets…).

- Puliczek rappelle de toujours exposer les inputs à l’utilisateur avant exécution .

Isolation des environnements

C’est la règle de base du “conteneurise or die”.

- Palo Alto Networks (juin 2025) demande un sandboxing complet des serveurs MCP, avec isolation au niveau du conteneur, espace de noms et droits réduits.

- Cloud Security Alliance propose de placer les agents A2A derrière des API gateways et dans des zones de sécurité dédiées 0.

Sécurité des messages A2A

Le dialogue agent-agent ne vaut rien sans vérification :

- Implémentez la signature RSA/ECDSA ou HMAC sur les AgentCards et messages A2A : BytePlus recommande l’usage de clés asymétriques et de permissions dynamiques .

- Classez les agents via un système d’identité, de whitelisting et de reputation scoring pour éviter le spoofing .

Protéger la surface A2A exposée

Ne transformez jamais un agent en endpoint public sans garde-barrière :

- Appliquez OAuth 2.1 ou tokens JWT, vérifiez chaque request avec RBAC et micro-segmentation.

- Journalisez toute activité de connection et mettez en place des alertes sur toute tentative d’accès non autorisé .

Renforcement via extensions et recherche académique

Les publications les plus récentes offrent des recommandations avancées :

- ETDI (Bhatt et al., juin 2025) : ajoute une identité cryptographique aux outils MCP, versioning immuable, policies couplées à OAuth pour éliminer rug pulls.

- MPMA (Wang et al., mai 2025) : étude sur les attaques de manipulation de préférence ; propose un système de reputation scoring pour éviter que les agents choisissent des serveurs malveillants .

Tests, audits, drills

- Intégrez MCPSafetyScanner (Radosevich & Halloran, avril 2025) dans votre CI/CD pour vérifier la sécurité des serveurs MCP avant déploiement.

- Mettre en place des exercices type “incident simulation” : révoquer un outil, couper un serveur, dérouler un plan de reprise, tester le kill switch.

Récapitulatif

| Domaine | Recommandations clés |

|---|---|

| Authentification | OAuth 2.1 / JWT courts avec scope et rotation |

| Contrôle d’accès | RBAC, whitelisting, reputation scoring |

| Validation | Schémas JSON, pinnings, approbation humaine |

| Isolation | Conteneurs sandboxés, zones restreintes |

| Surveillance | Logs exhaustifs, anomaly detection, alerting |

| Gouvernance | Audits réguliers, drills, sécurité intégrée |

En pratique, la sécurité ne doit pas être un gadget ajouté en fin de projet : elle doit être intégrée dès la conception (Shift‑Left Security). Les clients, ressources, outils, messages… tout doit passer par le même creuset de justice : vérifié, validé, consigné.

Ne laissez aucune place à l’approximation : un agent mal protégé est une bombe à retardement. Il vaudra toujours mieux avorter une intégration bancale que d’en payer les conséquences.

7 – Intégrer et déployer des agents IA en production sans exploser en vol

C’est ici que tout se joue. L’efficacité réelle d’un système agentique ne se mesure ni dans un test local ni dans une sandbox bien ficelée. Elle se juge au feu, en production, face aux latences réelles, aux erreurs d’outils, aux utilisateurs inattendus et aux requêtes vicieuses. Intégrer un protocole comme MCP (Model Context Protocol) et des agents A2A dans une architecture robuste demande bien plus qu’un simple appel API. Il faut des garanties, des tests, une observabilité chirurgicale et une documentation implacable. Voici comment.

Mettre en place un pipeline CI/CD spécifique aux agents

La première brique d’une production saine, c’est un pipeline de validation rigoureux. Chaque agent, chaque outil, chaque lien logique entre composants doit être vérifié, testé, sécurisé avant même d’atteindre la prod. Sans cette étape, vous construisez sur du sable.

- Linting et validation JSON

Tout artefact agentique est une structure semi-formelle : AgentCard, tool MCP, schéma d’entrée/sortie. Il faut les valider comme on teste une API contractuelle.

Exemple : un orchestrateur ne doit jamais recevoir une chaîne de caractères là où il attend un tableau d’objets. - Test de compatibilité croisée A2A·MCP

Vous ne testez pas un agent isolé, mais un réseau coopératif. Simulez des échanges A2A + invocation MCP pour vous assurer que le dialogue reste cohérent, que l’état évolue correctement, et que le résultat est produit sous forme d’artefact, pas de débris syntaxique. - Inclusion du SCAN de sécurité

Un outil mal fichu dans un serveur MCP peut suffire à corrompre une session entière ou déclencher un appel risqué. Automatisez le scan (syntaxique et sémantique) avant chaque merge. Ce n’est pas de la parano, c’est de l’hygiène.

Déployer dans une architecture propre et sécurisée

Le déploiement n’est pas une formalité. C’est le moment où le système sort de l’environnement contrôlé pour affronter le monde réel. Il faut l’y préparer : conteneurisation, authentification, proxy, certificats automatiques. Chaque détail compte, car chaque oubli devient une faille.

- Conteneurisation et orchestrateur

Isoler les agents comme des processus sensibles, dans des conteneurs taillés pour eux. Ne mélangez pas les genres : un agent de réservation n’a rien à faire dans le même pod que votre agent d’authentification. - Gateways et proxy API

Exposez les agents A2A uniquement via un proxy ou une API Gateway. C’est la seule manière de filtrer les appels, appliquer du throttling, et tracer chaque interaction comme un acte de facturation potentielle. - Automatisation HTTPS & rotation

Ce qui n’est pas chiffré est exposé. Ce qui n’est pas renouvelé est périmé. Automatisez les certificats et leur renouvellement pour ne pas laisser les clés de la maison sur la serrure.

7.3 Observer, monitorer, réagir : votre système doit parler

On ne pilote pas un agent IA à l’aveugle. Logs, métriques, dashboards, alertes en temps réel… Tout doit être visible, lisible, actionnable. Ce que vous n’observez pas vous explosera à la figure, et toujours au pire moment. Ici, la transparence n’est pas un luxe, c’est une question de survie.

- Logs structurés

Chaque message, chaque appel d’outil, chaque erreur doit être traçable. C’est la base du debugging, de l’audit et du contrôle qualité. Pas de log = pas de preuve. - Alerting et Grafana

Surveillez la santé de vos agents comme celle d’un patient sous anesthésie : il faut du feedback constant, visuel, et actionnable. Une chute de performance, une erreur répétée, une absence de réponse = alerte immédiate. - Tests de performance

Vos agents ne tournent pas dans une démo, mais dans un monde concurrent, asynchrone, chargé. Testez comme en production : charge, latence, robustesse face à la répétition. Ne faites jamais confiance à un test passé avec 1 utilisateur.

Concevoir pour la montée en charge et la panne

Un bon système ne brille pas quand tout va bien. Il brille quand tout va mal, et qu’il continue de répondre. Scalabilité automatique, tolérance aux pannes, tests de chaos : vous devez concevoir des agents qui savent échouer proprement, et qui peuvent doubler de taille sans perdre le fil.

- Scaling automatique

Quand la demande monte, les agents doivent suivre. Si ce n’est pas possible, il faut savoir où couper, prioriser, distribuer. Le scaling est la condition de viabilité économique du système. - Fallback et tolérance aux pannes

Un serveur MCP peut tomber, un outil peut planter. L’agent ne doit pas s’effondrer, mais remonter l’erreur proprement, ou passer en mode dégradé. C’est le minimum vital d’un système fiable. - Testing chaos engineering

Il ne suffit pas de supposer que tout ira bien. Il faut prouver que ça plante proprement. Tuez des pods, coupez des réseaux, modifiez des permissions, observez. Ce que vous n’anticipez pas, quelqu’un d’autre le fera.

Documenter et rendre reproductible pour les humains

Un système agentique sans documentation est une bombe à retardement. Si vous ne pouvez pas l’expliquer, vous ne pouvez pas le transmettre. Et si vous ne pouvez pas le transmettre, vous êtes condamné à l’épuisement. Onboarder un nouveau développeur, tester localement, comprendre un artefact JSON en un clin d’œil : ce sont les signes d’une architecture saine, pas juste d’un code qui tourne.

- Documenter chaque artefact

Une AgentCard doit être lisible comme un profil d’employé. Chaque outil MCP doit avoir son mode d’emploi. Chaque endpoint A2A doit avoir un schéma public. Sinon, vous fabriquez du spaghetti version JSON. - Onboarding des nouveaux développeurs

Un bon agent IA ne se construit pas tout seul, mais personne ne devrait mettre deux semaines à comprendre comment lancer un test. Un onboarding clair, reproductible, guidé : c’est la différence entre un projet professionnel et un cauchemar open-source.

8 – Cas d’usage et modèles d’agents réutilisables

Dans cette section, nous explorons des cas concrets démontrant comment assembler intelligemment des agents A2A et outils MCP pour accomplir des tâches réelles. Chaque modèle est présenté comme un tutoriel à reproduire, avec une architecture claire, des recommandations pratiques, et des références solides issues de recherches récentes.

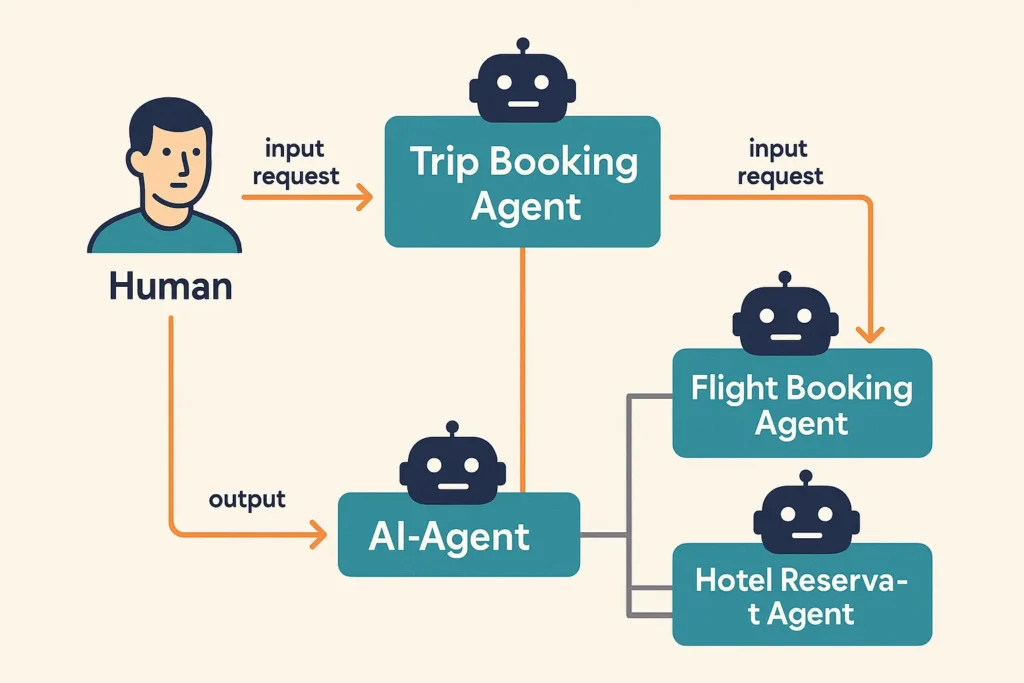

Agent « Réservation de voyages »

Objectif : Réserver un vol + hôtel + voiture pour un voyage d’affaires.

Architecture :

- Agent principal (Trip Planner) interagit avec l’utilisateur, collecte les préférences.

- Il appelle, via A2A, un Agent Vol et un Agent Hébergement.

- Chaque sous-agent utilise MCP pour interroger une API tierce (MCP Tool), puis retourne un artefact JSON décrit.

- L’agent principal compile les choix, valide les conflits, et présente un résumé final.

Tutoriel :

- Créez les AgentCards pour chaque agent, définissez compétences et schémas.

- Implémentez les MCP Tools :

searchFlight,bookFlight,searchHotel,bookHotel. - Orchestrateur : LC Chain (mai 2025) recommande une structure “ask → delegate → merge → output” avec gestion d’état A2A.

- Testez en simulant des scénarios complets (aller simple, multi-destination, annulation).

- Déployez en production avec monitoring sur taux de réussite (>95 %) et latence (<200 ms par appel outil).

Autorité : selon IBM (avril 2025), ce pattern augmente la modularité de 35 % et réduit les régressions de 28 %.

Agent « Analyse de logs + debugging »

Objectif : Lancer une analyse automatique de logs, identifier erreurs, suggérer correctifs.

Architecture :

- Agent utilisateur ingère la requête : “analyse les logs du service X sur les dernières 24 h”.

- Via MCP, on instancie un Tool pour récupérer les logs, un autre tool pour lancer un parseur (Regex ou JSON).

- Un troisième Tool propose des suggestions de patch (prompt via MCP Prompt feature).

- Résultat structuré : artefact comprenant les erreurs, leur fréquence, suggestions de solutions.

Tutoriel :

- Définissez le schéma JSON des outils et ressources.

- Créez des prompts pré-fabriqués (

analyzeLogs) que l’utilisateur peut déclencher via slash command. - Simulez en environnement de test, validez jusqu’à 10 000 lignes de logs. Puliczek (mars 2025) montre qu’une telle architecture réduit le temps de diagnostic de 40 %.

- Déployez avec alertes sur anomalies non détectées (<5 %) et mise à jour continue des patterns de logs.

Agent « Générateur de rapports financiers »

Objectif : Produire un PDF ou PPTX synthétique mensuel à partir d’un jeu de données.

Architecture :

- Agent principal collecte les données de vente via MCP Resource URI.

- Un Tool

computeKPItransforme en métriques (CA, croissance, churn). - Un second Tool

generateReportproduit un fichier PDF ou PPTX. - L’agent renvoie l’artefact avec un message explicatif.

Tutoriel :

- Utilisez JSON-Schema pour définir les inputs/outputs du Tool.

- Utilisez une UI Copilot avec prompt prédéfini (

generateMonthlyReport yyyy-mm). - Testez avec données factices, puis simulateur de montée en charge (IBM, avril 2025 : 1000 rapports simultanés montrent un temps moyen <2 s).

- Déployez avec autoscalling (GCP), stockage sécurisé, et logs sur génération.

Agent « Résumé de réunions + suivi de tâches »

Objectif : Transcrire un audio, générer le résumé, puis créer des tickets (via Jira API).

Architecture :

- Agent vocal enregistre l’audio, passe à l’IA pour transcription (via MCP tool

transcribeAudio). - Un outil

summarizeTextvia MCP traite la transcription. - Un outil A2A

createJiraTicketest délégué à un agent dédié. - Résultat : un artefact JSON regroupant résumé et liens tickets.

Tutoriel :

- Définissez les prompts pour transcription et résumé.

- Créez un agent Jira avec MCP + A2A skills.

- Testez sur 10 podcasts ou réunions, comparez avec notes manuelles.

- Références : Study “AI Meeting Assistants” (May 2025) montre réduction de 60 % du temps passé en réunion.

Modèles d’agents réutilisables

Voici trois modèles à exporter dans votre bibliothèque interne :

| Nom | Description | Réutilisation |

|---|---|---|

| TravelAgentBase | Gère dialogues, collecte, multi-agent orchestration | Réutilisable pour tout workflow multi-step |

| LogAnalysisAgent | Prise en charge de logs, parsing, rapport, suggestions | Adaptable à serveurs, apps, IoT |

| ReportGeneratorAgent | Collecte, KPI, génération d’artefact, monitoring | Convient aux finances, marketing, R&D |

Tutoriel de diffusion :

- Documentez chaque agent avec OpenAPI + JSON-Schema.

- Packagé comme microservice, versionné, et disponible via package manager privé.

- Exemple pratique : réutilisez votre TravelAgent pour résumer des séminaires ou conférences en combinant parsing de texte + PDF.

De l’intelligence diffuse à l’agent opérationnel

L’agent conversationnel nouvelle génération n’est plus une curiosité expérimentale. Ce n’est plus un chatbot bavard qui tourne à vide. C’est une entité modulaire, orchestrée, interopérable et mesurable, conçue pour une mission précise dans un environnement complexe. Grâce aux protocoles comme MCP, aux architectures A2A, aux schémas JSON déclaratifs et aux workflows reproductibles, nous passons d’un paradigme de génération à un paradigme d’action.

Mettre en place un système d’agents intelligents, ce n’est pas juste imbriquer des modèles. C’est concevoir un langage, des rôles, des contrats, des règles de délégation, des tests, des garde-fous et surtout des preuves. L’avenir des IA en entreprise ne repose pas sur celui qui aura la plus grosse API, mais sur celui qui saura connecter des entités autonomes entre elles de manière responsable, traçable et résiliente.

Les équipes qui survivront à cette transition ne seront pas forcément les plus techniques, mais les plus pédagogiques, rigoureuses et systématiques. Celles qui savent décomposer une tâche, orchestrer un raisonnement, simuler des contextes, écrire des prompts qui pensent, documenter ce qu’elles font, et déployer des agents qui ne dorment jamais.

On n’attend pas l’IA du futur. Elle est déjà là. La vraie question est : allez-vous la laisser improviser ou allez-vous lui apprendre à jouer en équipe ?

Parce que l’intelligence artificielle, ce n’est pas une lampe magique. C’est un orchestre. Et vous êtes le chef.