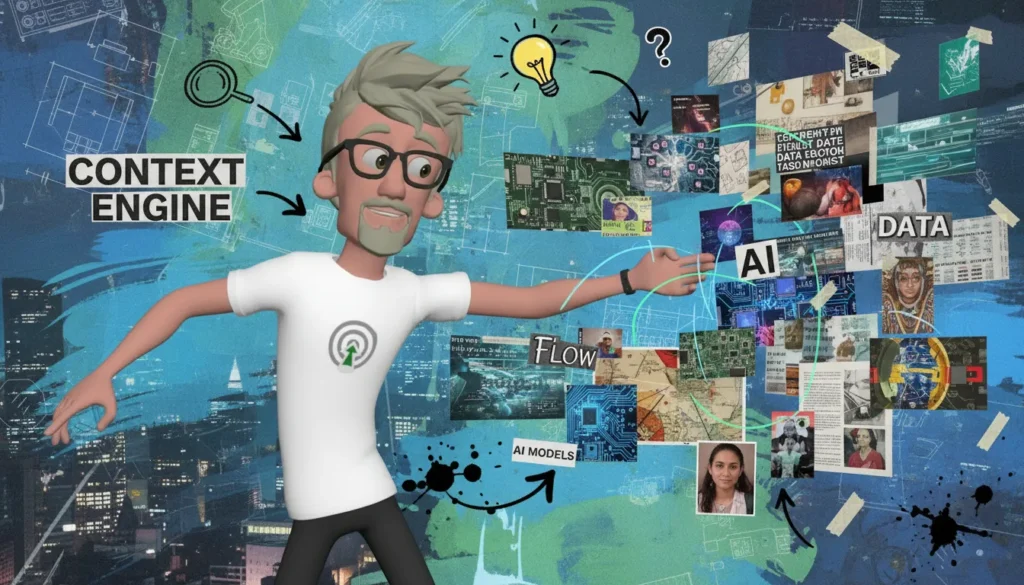

La context engineering supplante la prompt engineering en créant des environnements où l’IA peut raisonner de façon cohérente, au-delà du simple mot à mot. Ce changement fondamental garantit stabilité, mémoire et pertinence dans les interactions, une avancée cruciale pour passer du gadget à l’outil fiable en entreprise.

3 principaux points à retenir.

- La prompt engineering est limitée par sa fragilité linguistique, inefficace à grande échelle.

- La context engineering construit des systèmes avec mémoire, structure et continuité pour un raisonnement stable.

- La collaboration IA-humain s’enrichit via des environnements adaptés, dépassant la simple commande textuelle.

Quelles sont les limites de la prompt engineering ?

La prompt engineering repose sur des formulations d’une précision chirurgicale, mais elle se révèle intrinsèquement fragile et instable dans des contextes réels. Pourquoi cela ? Parce que, bien souvent, les prompts sont comme des mots de passe : une légère variation, et c’est la porte qui se verrouille. Cette méthode, bien qu’alléchante dans des expériences isolées, ne parvient pas à s’étendre au-delà des cas d’usage ponctuels. Imaginez une startup qui a créé un prompt parfait pour une tâche unique, mais dès que cette tâche doit s’intégrer dans un workflow d’entreprise plus vaste, les failles se révèlent : oublis, interprétations erronées, ou même des variations suscitées par le moindre changement de mot. Catastrophes en chaîne garanties !

Un des plus grands écueils de la prompt engineering est son incapacité à maintenir une mémoire cohérente. Les modèles d’IA oublient ou dévient, tout comme un élève qui change de professeur et qui n’arrive plus à suivre. Dans le cadre de petites expérimentations, cette instabilité est tolérable, mais dans un environnement de production, où la cohérence et la mémoire sont indispensables, cela devient un véritable terrain miné. Les ingénieurs se retrouvent à devoir alimenter sans relâche ces modèles avec des contextes spécifiques, un processus épuisant qui nuit à l’efficacité.

Intégrez l’IA Générative (GenAI) dans votre activité

Nos formations IA Générative (GenAI) et prompt engineering sont conçues pour les équipes qui veulent apprendre à exploiter les IA comme un pro. Vous y apprenez à structurer des prompts efficaces, à exploiter les meilleurs outils (assistants IA type ChatGPT, générateurs d’images, audio et vidéo) et à les appliquer à vos vrais cas métiers : analyser vos données (GA4, BigQuery, CRM…), produire des contenus clairs et crédibles, prototyper plus vite et automatiser les tâches répétitives. Des ateliers 100 % pratiques, pensés pour les entreprises, pour gagner du temps, sécuriser vos usages et livrer des analyses et supports de décision de niveau pro.

En outre, les erreurs fréquentes telles que l’hallucination d’informations ou les incompréhensions dues à des nuances linguistiques posent également question. Une phrase mal tournée peut entraîner des réponses complètement à côté de la plaque, et l’angoisse de l’utilisateur monte en flèche. C’est ce constat qui a poussé l’industrie à opérer un changement de paradigme. Plutôt que de s’enliser dans cette quête de formulations parfaites, il est devenu évident qu’il était temps d’investir dans une nouvelle approche : celle de la context engineering.

Cette transition vers le contexte comme fondement de la fiabilité des IA n’est pas simplement une tendance : c’est une nécessité.

Comment la context engineering améliore-t-elle l’intelligence artificielle ?

La context engineering, ou l’ingénierie du contexte, se présente comme la réponse à une question cruciale : comment créer des environnements où l’intelligence artificielle peut réfléchir avec profondeur, cohérence et intention? Contrairement à la prompt engineering, qui se focalise sur l’art de formuler des requêtes intelligentes, la context engineering intègre des éléments essentiels tels que les données, la mémoire, les métadonnées et des structures narratives pour renforcer le raisonnement des modèles d’IA.

Au cœur de cette discipline, on trouve les fenêtres contextuelles, qui déterminent la quantité d’information que l’IA peut traiter à un moment donné. C’est comme si on organisait un buffet où chaque plat représente une donnée. Plus la sélection est variée et bien présentée, mieux l’IA peut s’en servir. En effet, des modèles comme ceux utilisant la génération augmentée par récupération (RAG) permettent à l’IA de puiser dans des bases de connaissances externes au moment opportun, garantissant ainsi que chaque réponse soit ancrée dans une information vérifiable.

La mémoire stratégique est une pièce maîtresse dans cette architecture. Alors que la prompt engineering se limite à une interaction ponctuelle, la context engineering transforme chaque échange en une partie d’une histoire en évolution. Cela signifie que l’IA apprend, se souvient des erreurs et ajuste sa manière de répondre en fonction de l’interaction passée. Imaginez une conversation où l’IA se souvient de vos préférences stylistiques ou de vos projets précédents. Cette continuité renforce la relation entre l’utilisateur et le modèle, présentant un niveau d’empathie que les simples prompts ne peuvent atteindre.

Aujourd’hui, la context engineering est l’interface réelle pour l’IA. Elle établit un langage de cohérence qui surpasse la simple syntaxe. Les ingénieurs construisent des systèmes qui pré-chargent l’IA avec le bon contexte avant chaque requête, ce qui permet un raisonnement plus stable et adapté. C’est un changement de paradigme fondamental pour la fiabilité des systèmes, prouvant ainsi que l’avenir de l’IA ne repose pas sur des formulations astucieuses, mais sur des contextes soigneusement élaborés.

Quels sont les principes architecturaux derrière la context engineering ?

La context engineering se révèle une discipline novatrice, proche de l’urbanisme cognitif, où l’organisation des données et de la mémoire se fait selon des couches hiérarchisées. Imaginez un architecte qui dessine un plan complexe pour réaliser une ville cohérente. C’est le même processus ici, mais pour structurer la manière dont un modèle d’IA interprète l’information.

- Identité persistante : La première couche s’assure que le modèle sait qui est l’utilisateur, ce qu’il recherche et quel type de réponse lui est adapté. C’est là que la personnalisation entre en jeu, permettant au modèle d’offrir des réponses précises et pertinentes en fonction du contexte historique avec l’utilisateur. Cela garantit non seulement une interaction sans faille, mais aussi un rapport de confiance.

- Données externes actualisées : Ensuite, on a les données provenant d’APIs ou de bases de données qui sont pertinentes et à jour. Cette couche permet aux modèles d’accéder à une information en temps réel, essentielle pour que les réponses restent contemporaines et connectées à la réalité. Cela nourrit le modèle de un flux constant d’informations fraîches.

- Mémoire transitoire et adaptative : La troisième couche est dynamique et évolutive. Ici, le modèle adapte ses réponses en temps réel selon les directions prises par la conversation. Cette mémoire n’est pas infini, car trop d’informations peuvent mener à de la confusion. La clé est une gestion équilibrée entre ce qui doit être retenu et ce qui peut être oublié. Ce processus rappelle la nature humaine, qui filtre les informations pour ne garder que l’essentiel.

Pour éviter que le modèle ne « hallucine » ou parte dans des tangentes inattendues, il faut trouver cet équilibre délicat entre le contexte et la surcharge d’informations. Un peu comme un chef cuisinier qui doit contrôler la variété des saveurs sans rendre son plat trop compliqué, on doit veiller à ce que le modèle ne soit pas submergé par trop d’éléments.

Les embeddings, les schémas et la logique de récupération jouent un rôle crucial dans la « carte mentale » de la machine. Ils fonctionnent comme le système de transit d’une ville, permettant au modèle de naviguer efficacement à travers les différentes couches d’information. Ces éléments forment une base solide pour l’ingénierie contextuelle, transformant une approche centrée sur la commande en une collaboration où l’IA devient un véritable partenaire dans l’arène des idées et de la compréhension.

Comment la context engineering transforme-t-elle la collaboration avec l’IA ?

La revolution marquée par la context engineering transforme radicalement la manière dont nous collaborons avec l’intelligence artificielle. Finies les interactions où nous commandions des réponses au gré de nos envies. Place à une nouvelle danse, où l’IA devient un véritable partenaire, rugissant d’intelligence et capable de se souvenir des nuances de chaque échange. Cette fusion réussie ressemble à une chorégraphie sans fausse note, où les mouvements s’ajustent et s’interprètent avec finesse.

Pensons à un assistant virtuel dans un environnement professionnel. Imaginez que ce dernier ne se contente pas d’exécuter des tâches basiques selon des instructions prédéterminées. Au contraire, il se souvient de vos préférences stylistiques et des décisions prises lors de réunions passées. Cela n’est pas qu’une simple fantaisie; cela exemplifie comment, à travers des systèmes de mémoire évolutive, l’IA peut rappeler des échanges précédents et prendre en compte les intentions longues de l’utilisateur. Cette logique de collaboration fait émerger un amalgame d’empathie, de continuité et de pertinence dans les réponses fournies.

La magie opère dans des cas d’usage concrets. Prenons un exemple tiré du monde de l’éducation, où une IA fournit des recommandations de lecture. Au lieu de proposer aveuglément des titres, elle tient compte des livres que l’élève a précédemment aimés, de ses commentaires sur ceux-ci, et adapte ses suggestions à ses goûts personnels. Chaque interaction devient une occasion d’enrichir la mémoire de l’IA, formant à la longue une bibliothèque de ses préférences.

Cette transition, de l’instruction à une co-construction dynamique, distingue profondément la nature de nos relations avec les machines. Au lieu de passer par un système de commande/réponse rigide, nous cultivons une synergie où l’IA apprend de ses interactions, s’ajuste et évolue avec nous. C’est un autre niveau de complicité qui s’établit, rendant nos échanges non seulement plus fluides, mais surtout plus significatifs sur le long terme.

Pourquoi la context engineering est-elle la clé des IA plus fiables et adaptatives ?

La mémoire contextuelle est un véritable trésor dans le monde de l’IA, mais attention : elle n’est pas infinie ! Elle est astucieusement gérée pour garantir que seules les informations pertinentes restent, éliminant ainsi tout le bruit qui pourrait parasiter le raisonnement de nos algorithmes chéris. Comment ça fonctionne, au juste ? C’est un subtil mélange de sélection, compression et oubli sélectif. Ainsi, un modèle intelligent s’appuie sur ce qu’il a appris de l’instant présent et du passé, sans se laisser submerger par une avalanche d’informations inutiles.

Imaginez un assistant client, par exemple, qui n’a pas seulement accès à votre demande en cours, mais qui se rappelle de vos interactions passées. C’est ce que l’on appelle l’empathie contextuelle. Lorsqu’un agent traite une réclamation, il peut consultez le dossier du client, son historique d’achat et même ses soucis antérieurs, tout cela sans un « trop » d information qui nuirait à la clarté des échanges. Ce modèle de mémoire renforcée n’est pas là pour faire joli, mais pour rendre les interactions plus fluides et intelligentes.

Dans le domaine de l’analyse de données, avoir un cadre contextuel où se souvenir des analyses passées et des résultats précédents est crucial. Cela signifie que les analystes ne réinventent pas la roue à chaque projet, mais s’appuient sur une base solide de connaissances établies, adaptant les conclusions précédentes pour prendre des décisions plus éclairées. C’est ce genre de raisonnement qui propulse les entreprises vers l’avenir.

Et qu’en est-il de la créativité ? Pensez à ces outils génératifs d’images qui exploitent des contextes empilés pour livrer des rendus d’une qualité saisissante. La capacité à se souvenir et à lire entre les lignes des tendances permet de produire des œuvres qui semblent presque humaines. La connaissance contextuelle devient la clé non seulement de l’efficacité mais aussi de l’innovation.

À l’avenir, chaque workflows IA sera inévitablement bâti sur cette ingénierie du contexte. Ce n’est pas un gadget, c’est un véritable saut qualitatif qui garantit robustesse et alignement des systèmes à travers les différentes branches industrielles. Ignorer cette dynamique serait une grave erreur pour quiconque aspire à rester compétitif dans le domaine de l’intelligence artificielle. Et vous, êtes-vous prêt à embarquer dans cette nouvelle ère ?

Et si la vraie maîtrise de l’IA passait par l’ingénierie du contexte ?

L’époque des prompts magiques est finie. Désormais, pour des interactions IA fiables et pertinentes, il faut penser en environnement, pas en simples requêtes. La context engineering offre le socle pour bâtir une intelligence artificielle qui comprend, se souvient et collabore véritablement avec l’humain. Adopter cette approche, c’est garantir que vos solutions d’IA ne se contentent plus de réponses approximatives, mais évoluent en véritable co-intelligence. Le bénéfice est clair : des systèmes plus robustes, alignés, et prêts à transformer les usages pro.

FAQ

Qu’est-ce que la prompt engineering et pourquoi est-elle limitée ?

En quoi la context engineering améliore-t-elle l’IA ?

Comment la mémoire est-elle gérée dans la context engineering ?

Quels secteurs profitent le plus de la context engineering ?

Quelle est la différence entre collaboration IA et simple commande textuelle ?

A propos de l’auteur

Franck Scandolera cumule plus de dix ans d’expérience en analytics et data engineering, avec une expertise reconnue dans l’automatisation et la mise en œuvre d’IA générative pour les entreprises. En tant que responsable d’agence webAnalyste et formateur indépendant, il accompagne les professionnels à structurer leurs données et à intégrer des workflows IA robustes, alliant mémoire, contexte et automatisation pour garantir des systèmes performants et durables.